In questo nuovo appuntamento della rubrica dedicata alla gestione del colore nel workflow del fotografo, l’Ambassador EIZO Marco Olivotto ci spiega come nasce il colore e perché scattare in RAW è meglio, ma con qualche eccezione…

La natura della luce: onde o fotoni?

La luce è radiazione elettromagnetica (o un’onda elettromagnetica), un’entità fisica caratterizzata da un parametro chiamato lunghezza d’onda. Il sistema visivo umano reagisce solo a un piccolo intervallo di lunghezze d’onda, detto spettro visibile. All’interno dello spettro visibile, la lunghezza d’onda è associata alla sensazione che chiamiamo colore. In certi contesti, la luce si comporta però come se fosse composta da particelle chiamate fotoni. I fenomeni ondulatori e quelli particellari hanno poco in comune, e non è semplice spiegare il dualismo onda-particella. Per quanto ci riguarda, in questo articolo possiamo considerare la luce come un insieme di particelle in grado di trasportare energia…

Come funziona un sensore?

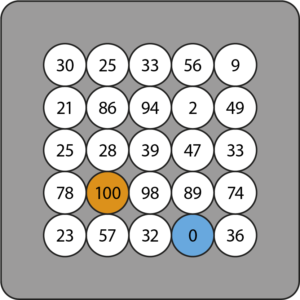

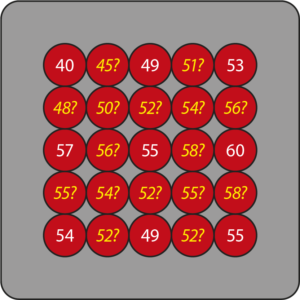

Il sensore della nostra macchina fotografica è composto da milioni di “fotositi”: piccole cavità che fungono da contatori di fotoni. La figura 1 schematizza una porzione di sensore vista frontalmente. Quando un fotosito è colpito dalla luce, emette un segnale elettrico proporzionale al numero di fotoni rilevati. Questo segnale, convertito in forma digitale, fornisce informazioni sull’intensità della luce che ha colpito ciascun fotosito. I numeri (che ipotizziamo variabili tra 0 e 100) corrispondono al numero di fotoni catturati da ciascun fotosito. In altri termini, viene a crearsi una sorta di mappa di luminosità: una forma elementare di fotografia!

Figura 1 – Rappresentazione schematica di una porzione di un sensore.

La figura 1 mostra anche due fotositi di colore arancione e ciano. Come possiamo vedere, questi riportano un conteggio pari a 100 e a 0, rispettivamente il massimo e il minimo ammissibile. Il primo valore è importante: un sensore, come qualsiasi strumento di misura, ha una soglia superiore oltre la quale non è in grado di operare. Se 110 fotoni incidessero su un fotosito, il conteggio resterebbe pari a 100: dieci fotoni verrebbero persi, come l’acqua che traboccasse da un secchio colmo fino all’orlo. Una lettura pari a 100, quindi, non fornisce alcuna informazione sull’intensità luminosa precisa del segnale incidente su quel punto del sensore: i fotoni avrebbero potuto essere esattamente 100, oppure 143, o addirittura 1.000! Il fenomeno prende il nome di clipping e causa una perdita d’informazione: le parti sovraesposte di una fotografia appaiono piatte, perché non è possibile rilevare una variazione potenzialmente esistente nella realtà al momento dello scatto. Il fotosito evidenziato in ciano si situa invece all’estremo opposto: non rileva alcun fotone perché l’intensità della luce incidente è troppo bassa per essere misurata. Il sensore ha quindi anche una soglia inferiore di sensibilità, al di sotto della quale un segnale risulta non misurabile. I conteggi attuati dai fotositi contribuiscono a formare l’immagine RAW, letteralmente “grezza”. C’è però un problema: i fotositi sono in grado di contare i fotoni, ma non ne distinguono la lunghezza d’onda. La lunghezza d’onda è legata al colore che percepiamo, quindi i fotositi non sono in grado di rilevare il colore della luce. Questo significa che, per il sensore, 50 fotoni provenienti da una sorgente monocromatica rossa sono identici a 50 fotoni provenienti da una sorgente monocromatica verde. In definitiva, il sensore è cieco al colore!

Da dove viene il colore?

D’altronde, le fotografie che scattiamo ci appaiono a colori, in apparente contraddizione con quanto appena esposto. La riproduzione del colore è resa possibile da un’ingegnosa tecnologia che antepone al sensore un filtro a mosaico, detto anche “filtro di Bayer”. Una macchina fotografica priva del filtro di Bayer (per esempio la Leica M Monochrom) produrrà soltanto immagini in bianco e nero. Esiste anche una tecnologia sviluppata da Foveon in grado di realizzare sensori che codificano il colore senza filtri, ed è utilizzata nelle fotocamere Sigma. Da qui in avanti, però, ci riferiremo sempre ai sensori “tradizionali”.

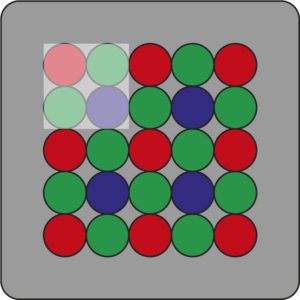

Figura 2 – Il classico layout del filtro di Bayer.

La figura 2 mostra uno degli schemi di realizzazione più comuni del filtro a mosaico: a ciascun fotosito è anteposto un filtro colorato. Di solito i filtri sono organizzati in gruppi di quattro, disposti come nel riquadro più chiaro, due sopra e due sotto: l’ordine è R-G-G-B, ovvero rosso-verde-verde-blu. Lo schema si ripete ricoprendo tutto il sensore. Se si considera che la dimensione lineare di un fotosito è dell’ordine di pochi micron (milionesimi di metro), si comprende come la tecnologia di realizzazione dei filtri sia estremamente raffinata. Complessivamente, i fotositi risultano coperti per un quarto da filtri rossi, per metà da filtri verdi e per un quarto da filtri blu. Ciascun filtro trasmette soltanto la componente luminosa del proprio colore, assorbendo le altre due. Ad esempio, un segnale monocromatico rosso incidente su un filtro rosso viene trasmesso completamente, mentre lo stesso segnale incidente su un filtro verde o blu viene assorbito. Il risultato è che nel primo caso il fotosito sottostante registra tutti i fotoni presenti nel segnale, nel secondo non ne registra nessuno. Ciascun fotosito riceve quindi soltanto le informazioni relative alla componente cromatica definita dal filtro a esso associato. Questo è un problema, perché servono tre componenti per codificare un colore: se in ciascun fotosito due componenti rimangono indefinite, dobbiamo trovare un modo per recuperare le informazioni mancanti.

Ogni fotosito “vede” solo un colore

La figura 3 mostra la situazione in riferimento alla componente rossa della luce.

Figura 3 – Ogni elemento del sensore è sensibile soltanto al proprio colore di riferimento.

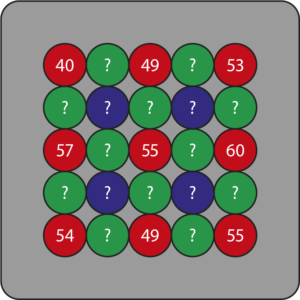

Ne conosciamo il valore in un quarto dei fotositi; nei tre quarti rimanenti invece non abbiamo idea di quale possa essere la sua intensità. Quando osserviamo un’immagine digitale non vediamo però “buchi” nei canali del rosso, verde o blu. I valori mancanti vengono costruiti grazie a una tecnica matematica chiamata “interpolazione”. Essenzialmente, vengono calcolati dei valori medi basati sui valori registrati dai fotositi circostanti. Lo schema è visibile in figura 4: i valori in giallo hanno un punto di domanda perché stiamo letteralmente tirando a indovinare. Non abbiamo alcuna certezza sul fatto che il valore compreso tra 40 e 49 sia realmente 45: potrebbe essere 44, ma anche 71.

Figura 4 – Il processo di interpolazione “tira a indovinare”.

Ci basiamo sull’ipotesi che le variazioni tra un punto e l’altro debbano essere sufficientemente morbide, ma in realtà non lo sappiamo.

Cosa succede durante lo “sviluppo” dei RAW

Il processo d’interpolazione descritto nella sezione precedente si chiama “demosaicizzazione” ed è il cuore dello sviluppo di un’immagine RAW. Si può attuare in diversi modi, e più gli algoritmi d’interpolazione sono sofisticati, maggiore sarà il tempo di calcolo richiesto. Lo sviluppo rende fruibile l’immagine, perché senza di esso non la vedremmo affatto. Il nodo è che un’immagine RAW contiene informazioni parziali sul colore, ma non è a colori. Se volessimo rappresentare i dati RAW prima della demosaicizzazione, potremmo assegnare un’intensità luminosa a ciascun fotosito: il risultato sarebbe una strana immagine in bianco e nero, suddivisa in piccole celle che riflettono la struttura del filtro di Bayer e in generale molto scura. Per esemplificare, la figura 5 mostra una fotografia dopo lo sviluppo.

Figura 5

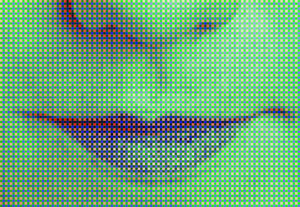

In figura 6, l’aspetto che avrebbe l’originale in formato RAW assegnando un valore di luminosità a ciascun dato rilevato dal sensore e la struttura delle celle del filtro di Bayer in un ingrandimento estremo, con il contrasto incrementato al fine di mettere in evidenza le singole componenti.

Figura 6

Se assegnassimo a ciascun pixel il colore del filtro relativo al fotosito che lo ha generato, prima della demosaicizzazione, otterremmo qualcosa di simile alla figura 7. È evidente che ciascun pixel può alternativamente assumere solo una tonalità di rosso, verde o blu, ma mai un colore corretto!

Figura 7

Quando un’immagine RAW viene aperta con un modulo di sviluppo (come Adobe Camera Raw), i dati vengono per prima cosa sottoposti alla demosaicizzazione e ad altre operazioni secondarie. In questo contesto, vengono assegnati dei parametri di sviluppo predefiniti (bilanciamento del bianco, esposizione, contrasto…) che producono una certa interpretazione dell’immagine, visualizzata nella finestra di anteprima. Spesso si sente definire l’immagine che appare in anteprima come “l’immagine RAW non sviluppata”. È un’assurdità: l’immagine è sviluppata, eccome. Inoltre, non è più in formato RAW, o non apparirebbe a colori. Ciò che vediamo è un’immagine raster pronta per entrare in Photoshop, con un solo problema: vive in uno spazio colore con caratteristiche particolari, ottimo nel contesto dello sviluppo, ma di difficile gestione in altri. Per questo impostiamo i parametri di sviluppo, realizzando una versione che ci soddisfa, e poi apriamo, se è il caso, l’immagine in Photoshop in uno spazio colore standard come Adobe RGB o ProPhoto RGB, a seconda delle nostre inclinazioni. Si tratta di due fasi distinte di post-produzione, con i loro pro e i loro contro. Detto questo, in nessun modo vedremo mai un’immagine RAW “non sviluppata”: nel momento in cui la fotografia risulta visibile, il grosso del lavoro è fatto e dobbiamo soltanto decidere quali parametri di sviluppo utilizzare.

La superiorità del RAW rispetto al JPEG, con le dovute eccezioni

Nel momento in cui chiediamo alla fotocamera di produrre un file JPEG, esiste comunque a monte un’immagine RAW che viene processata in base alle impostazioni della macchina e subito scartata. La post-produzione di base, che riguarda la scelta dello spazio colore, del bilanciamento del bianco, del picture style e via dicendo, avviene in macchina. Il formato RAW senza dubbio consente di recuperare immagini che altrimenti risulterebbero critiche se non irrecuperabili. Questo perché i dati RAW sono in grado di codificare una gamma dinamica più ampia rispetto ai dati in formato raster normalmente manipolati in Photoshop (TIFF o JPEG), ed è più agevole recuperare dettaglio nelle ombre e nelle luci. È peraltro azzardato affermare che il formato RAW offra sempre una qualità incomparabilmente maggiore rispetto a un’immagine raster: in numerosi casi, la differenza qualitativa tra un formato e l’altro è irrilevante dal punto di vista pratico, ed è perfettamente possibile (e in taluni casi più semplice) post-produrre un JPEG. Se la scena da riprodurre non ha una gamma dinamica eccessiva, una fotografia correttamente esposta può essere realizzata in JPEG senza perdita di qualità rispetto all’equivalente RAW.

Contrariamente a quanto si crede, scattare in JPEG risulta vantaggioso in diversi contesti professionali: ad esempio, quando si debbano realizzare fotografie di un gran numero di prodotti da pubblicare sul web. In questo caso, il tempo di elaborazione e post-produzione diventa cruciale, ed è più veloce lavorare un’immagine JPEG che un’immagine RAW. In alcuni casi, inoltre, ci troviamo davanti a problematiche estreme che i moduli di sviluppo non sono in grado di risolvere, ma che possono essere affrontate facilmente in Photoshop da un operatore esperto. Facciamo l’esempio di una foto scattata in condizioni anomale di luce (figura 8).

Figura 8 – Una foto scattate in condizioni di luce complicate. La dominante “calda” è fin troppo evidente.

Il bilanciamento del bianco in Camera Raw effettuato sul RAW originale prendendo come punto neutro la tovaglia in basso a sinistra non fornisce un buon risultato (figura 9), perché la temperatura di colore è troppo bassa.

Figura 9 – Bilanciare il bianco prendendo come riferimento la tovaglia in basso ha portato a toni troppo freddi.

L’enorme dominante dell’originale si rimuove però immediatamente in Photoshop (figura 10) con una regolazione antica ma essenziale: Miscelatore canale. Il punto neutro è lo stesso scelto per produrre la figura 9.

Figura 10 – Usando lo strumento Miscelatore canale, l’immagine finalmente mostra i colori che vedevano i nostri occhi al momento dello scatto.

L’immagine originale ha tre canali RGB: uno dei quali disastrato al punto che la sua eliminazione non cambia nulla. La tecnica di correzione comporta il rinforzo del canale malato con un altro, ma questo presume la capacità di analizzare l’immagine e manipolare direttamente i canali. Quando è necessario affidarsi ai principi di base che regolano le immagini digitali, Photoshop spesso vince sui moduli di sviluppo.

In definitiva, nessuno afferma che il formato RAW sia da evitare, ma solo che le prese di posizione unilaterali in questo campo sono dannose, perché la post-produzione non dovrebbe prescindere da un’analisi tecnica che coinvolga le immagini una per una. La fotografia non è una materia granitica in cui si possano stabilire regole generali valide sempre e in ogni caso: questo vale anche per la presunta superiorità assoluta del formato RAW rispetto al JPEG. C’è una battuta molto famosa di Dan Margulis: «Non esistono cattivi originali, ma solo cattivi operatori di Photoshop». In parte, è vero: in mano a qualcuno che sappia cosa stia facendo, Photoshop permette spesso di ottenere risultati di qualità superiore rispetto ai moduli di sviluppo RAW. Il prezzo da pagare è che talvolta il processo è più involuto e (raramente) più lento, ma se l’immagine è importante, la complessità dell’intervento e una possibile lentezza operativa non sono i problemi principali.

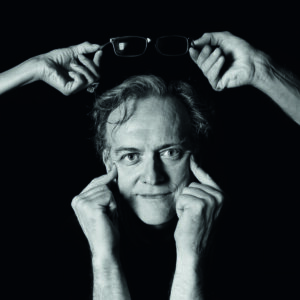

Chi è Marco Olivotto

Classe 1965, si laurea in fisica, ma lavora per anni come tecnico del suono e produttore musicale. Appassionato di fotografia fin da bambino, si avvicina presto alle tecniche digitali. La svolta avviene nel 2007, quando scopre i libri di Dan Margulis, padre della correzione del colore in Photoshop. Inizia a trasportare le tecniche apprese nella realizzazione grafica delle sue produzioni, fino a che nel 2011 inizia a insegnare gli stessi argomenti dopo avere seguito due corsi di teoria del colore applicata (base e avanzato) con lo stesso Margulis. Pubblica oltre 50 ore di videocorsi sulla materia con Teacher-in-a-Box, scrive a lungo per riviste specializzate, insegna in corsi post-diploma e universitari. Diventa speaker ufficiale per FESPA in diverse fiere internazionali e tiene corsi e workshop in Italia e Svizzera in diverse scuole (LABA, ILAS) e organizzazioni private. Ha collaborato in veste di consulente e formatore con realtà come Canon, Durst, Mondadori, Yoox, Angelini, Calzedonia, FCP Grandi Opere e altre. Si occupa di post-produzione fotografica e prestampa per diverse realtà editoriali. Nel 2016, la casa madre giapponese di EIZO lo ha nominato Ambassador nel primo gruppo di esperti formatosi attorno al marchio. marcoolivotto.com

Abbonati

Abbonati I nostri manuali

I nostri manuali LOGIN/REGISTRATI

LOGIN/REGISTRATI